Depuis septembre 2014, le service de Prêt Numérique en bibliothèque a démarré pour le grand public. Cela concerne pour l'instant les médiathèques des agglomérations de Montpellier, Grenoble et Aulnay sous Bois. Les usagers pourront ainsi profiter d'une offre de livres numériques "en streaming à l’intérieur de la bibliothèques ou en téléchargement du titre avec un DRM sur place ou à domicile"

il faut néanmoins télécharger au préalable Adobe Digital Reader pour que le transfert du livre numérique se fasse.[1]

Ce qu'il faut savoir c’est qu'à ce jour les ebooks ne sont pas achetés par les bibliothèques comme pour les versions papiers mais loués pour "une durée déterminée, via une licence de prêt" et la durée et les conditions varient selon les éditeurs. Ces livres sont achetés à l'unité et non sous forme de bouquet ce qui implique "un coût potentiel de plusieurs millions d'euros, sachant que le prix moyen d'un livre numérique du catalogue PNB est de 17,55 euros, chaque bibliothèque publique devrait débourser environ 175 000 euros pour le proposer à ses usagers. Or le budget moyen consacré aux ressources numériques par les villes de plus de 100 000 habitants et de 33 325 euros. Encore moins pour les plus petites villes."[2]

|

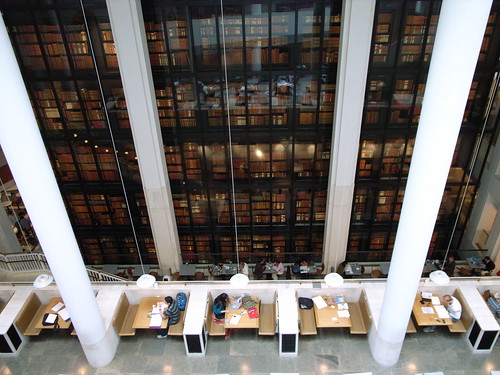

| La British Library (Steve Cadman, CC BY-SA 2.0) |

De plus le cadre juridique autour du PNB reste encore un véritable problème malgré "la signature [en décembre 2014] d’un protocole d’accord entre l’État, les bibliothèques, les éditeurs, les auteurs, les libraires et les élus culturels concernant la diffusion du livre numérique par les bibliothèques publiques".

En effet ces recommandations ne modifient en rien la loi sur le prêt en bibliothèque qui existe depuis 2003 en France et qui repose sur le mécanisme de licence légale. Il est dit dans ces "12 recommandations" que "les ayants droits définissent exclusivement les offres et les conditions d’accès aux livres numériques en bibliothèque publique. Le Ministère a souhaité que ces recommandations ne portent donc que sur le seul cadre légal possible, celui de la voie contractuelle." Ce que critiquent certains bibliothécaires dont l'association des bibliothèques de France (ABF) c'est le manque d’engagement réel du gouvernement pour une vraie modification de la loi sur le prêt en bibliothèque. Quatre nouvelles lois sont apparues ces dernières années autour du livre numérique ( la loi sur le prix unique du livre numérique, la loi sur les livres indisponibles du XXème siècle, la loi anti-amazon en faveur de la gratuité des frais de port et le code de la propriété intellectuelle vient d'être modifier et d’adapter le contrat d’édition à l'environnement numérique) et pourtant seul "12 recommandations" viennent de voir le jour.

QUID alors du prêt numérique en bibliothèque qui ne semble pas aller dans le même sens ? A ce jour les bibliothèques françaises doivent passer par le système de licence imposé par les éditeurs et force est de constater que 98% des bibliothèques en France ne proposaient pas de livres numériques en prêt en 2013, alors que 95% des bibliothèques américaines le font. [3]Sans oublier que chaque année les bibliothèques devront renouveler ces licences auprès des éditeurs et les prêts par les usagers ne seront téléchargeables qu'une trentaine de fois. Ce seront des prêts qui s’autodétruiront.

Il reste aussi le problème épineux des éditeurs : on sait qu'aujourd'hui en bibliothèque les achats sur les nouvelles parutions se font en même temps que les sorties en librairies puisque la loi sur le prêt papier en bibliothèque le permet, or il n'en est pas de même pour les ebooks car les éditeurs pensent que les ventes risquent d'être "cannibalisés par l'accès en bibliothèque". Mais le protocole signé en décembre précise pour empêcher ce blocage que l'intégralité de l'offre éditoriale doit être proposée aux bibliothèques.

Enfin, autre sujet d'inquiétude pour l'ABF : la collecte des données personnelles car les éditeurs imposent l'usage du DRM pour la diffusion des livres numériques auprès des usagers or l'on sait que Adobe collecte massivement les données pour connaitre les usages des lecteurs.

Ce projet de PNB en place depuis septembre et dont les "12 recommandations" viennent d'être signé en décembre 2014, montre une réelle volonté

de faire avancer les choses mais les contraintes restent nombreuses tant

sur la politique tarifaire que sur le contenu des livres ou le moyen de

télécharger les fichiers.

Sources :

[1] Le service de Prêt Numérique en Bibliothèque (PNB) est ouvert

jeudi 04 septembre 2014

https://www.actualitte.com/bibliotheques/le-service-de-pret-numerique-en-bibliotheque-pnb-est-ouvert-52375.htm [ consulté le : 17 février 2015]

[2] Garcia, Victor : Prêt numérique en bibliothèque: à peine acté, déjà critiqué, 19 décembre 2014

http://www.lexpress.fr/culture/livre/pret-numerique-en-bibliotheque-a-peine-acte-deja-critique_1633556.html#zOLsqo15hKQIdvSK.99 [ consulté le : 17 février 2015]

[3]Maurel Lionel : Livre numérique en bibliothèque : une démission de la politique de lecture publique

S.I.Lex, 12 décembre 2014

http://scinfolex.com/2014/12/12/livre-numerique-en-bibliotheque-une-demission-de-la-politique-de-lecture-publique/ [ consulté le : 17 février 2015]